Objetivos de Aprendizaje

● Comprender el Big Data y sus poderosos beneficios empresariales.

● Conocer las diferencias entre el Big Data y los datos convencionales.

● Conocer las 4 V's de Big Data: Volumen, velocidad, variedad y veracidad.

● Descubrir los tres tipos de aplicaciones empresariales de Big Data.

● Aprender valiosos consejos sobre cómo gestionar el Big Data.

● Conceptualizar el ecosistema de Big Data y sus componentes clave.

● Apreciar los principales retos tecnológicos en la gestión de Big Data.

● Relacionarse con las principales soluciones tecnológicas para afrontar esos retos.

Integralidad

"Big Data" (o grandes datos) representa las colecciones de datos caracterizadas por un volumen,una velocidad y una variedad tan grandes que su transformación en valor utilizable requiere el uso

de tecnologías y métodos analíticos específicos"

• Velocidad: los datos y los resultados suelen estar disponibles en tiempo real.

• Variedad: se basa en datos textuales, fotos, audio/vídeo y suele completar las piezas que faltan, mediante la fusión de múltiples fuentes.

Contexto de Big Data

Big Data - ¿Por qué?

• Aumento exponencial de la cantidad de datos no estructurados.

• Correo electrónico, chat, blog, web, música, foto, vídeo, etc.

• Aumento de la capacidad de almacenamiento y análisis.

• El uso de varias máquinas en paralelo se hace accesible.

• Las tecnologías existentes no están diseñadas para ingerir estos datos.

• Bases de datos relacionales (tabulares), mainframes, hojas de cálculo (Excel), etc.

• Se necesitan "Nuevas" tecnologías y técnicas analíticas.

• "Google File System" - Google 2003.

• "MapReduce: Simplified Data Processing on Large Clusters" - Google, 2004.

• Hadoop: circa 2006.

• De ahí "Big Data": no estrictamente más datos.

Dos Niveles de Big Data

● A un nivel fundamental, los Big Data son una colección más de datos que pueden ser analizados y utilizados en beneficio de la empresa.

● A otro nivel, es un tipo especial de datos que plantea retos únicos y ofrece beneficios únicos.

● La cantidad de Big Data es 1.000 veces mayor que la de los datos tradicionales.

● La velocidad de generación y transmisión de datos es 1.000 veces más rápida.

● Las formas y funciones de los Big Data son 10 veces más diversas: desde números hasta texto, imágenes, audio, vídeos, registros web, datos de máquinas, etc.

● Hay muchas más fuentes de datos, desde los individuos hasta las organizaciones y los gobiernos, utilizando una serie de dispositivos que van desde los teléfonos móviles hasta los ordenadores y las máquinas industriales.

● No todos los Big Data tienen la misma calidad y valor.

Caso Práctico: IBM Watson

P1: ¿Qué tipo de conocimientos, tecnologías y habilidades de Big Data se necesitan para construir un sistema como Watson?

¿Qué otros recursos se necesitan?

P2: ¿Podrán los médicos competir con Watson en el diagnóstico de enfermedades y la prescripción de medicamentos?

¿Quién más podría beneficiarse de un sistema como Watson?

Alcance de Big Data

¿Qué es Big Data?

“Big Data es el dominio del conocimiento que explora las técnicas, las habilidades y la tecnología para deducir ideas valiosas a partir de cantidades masivas de datos"

El Valor de Big Data.

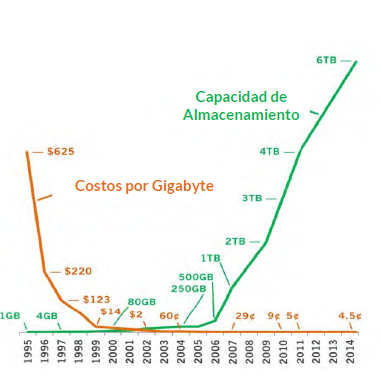

Big Data - Capacidad de almacenamiento:

• Entre 2000 y 2006, la capacidad de los discos aumentó en 10 veces, mientras que el precio por Gb cayó en la misma proporción, Un aumento de 100x a precio constante.

Breve Historia de Big Data

Las tres grandes fases de la historia del Big Data:

Análisis de Datos, Analítica, Inteligencia de Negocios y Big Data

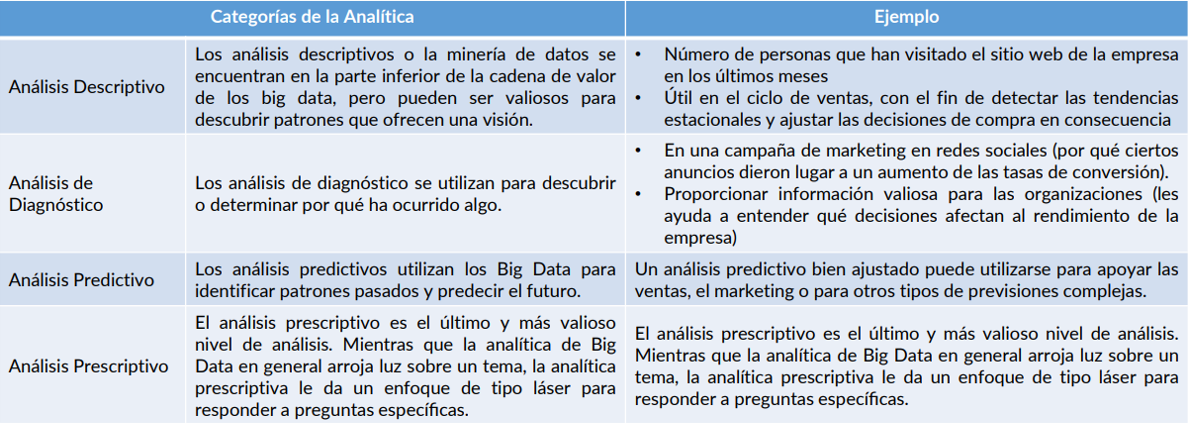

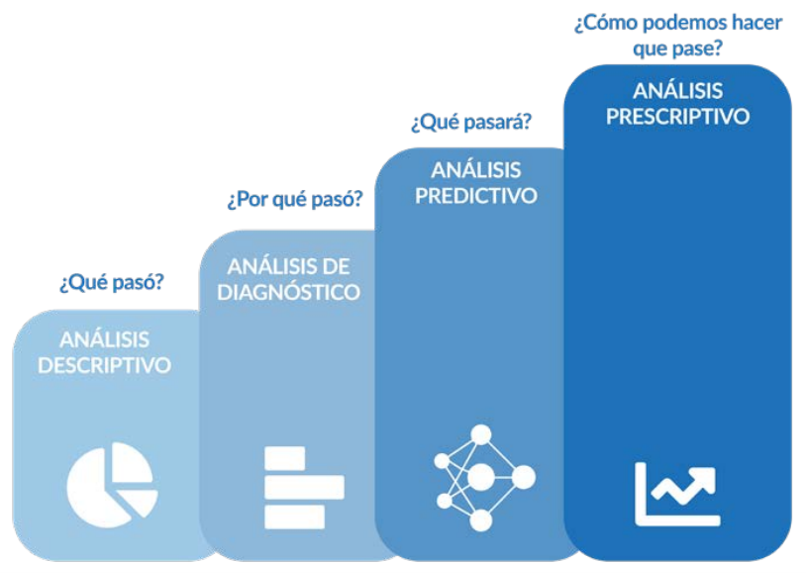

En el ámbito empresarial y científico, la mayoría de las organizaciones distinguen cuatro formas diferentes de identificación de patrones en un conjunto de datos:

● Análisis de Datos.

● Analítica.

● Inteligencia de Negocios (BI).

● Big Data (datos masivos).

Análisis de Datos

Definición:

El análisis de datos es un proceso de inspección, limpieza, transformación y modelado de datos con el objetivo de descubrir información útil, sugerir conclusiones y apoyar la toma de decisiones.

Propósito:

El objetivo principal del análisis de datos es revisar los datos existentes para describir patrones que han ocurrido en el pasado, por ello también se suele denominar análisis descriptivo de datos.

Ejemplo:

Un ejemplo de análisis de datos sería comprobar los patrones de venta de diferentes tiendas en los últimos años.

Análisis de Datos: Ejemplo

Figura 2: Análisis de Datos: Patrones de Venta en las Tiendas

Analítica

● La analítica es el descubrimiento, la interpretación y la comunicación de patrones significativos en los datos.

● La analítica es especialmente valiosa en áreas ricas en información registrada, se basa en la aplicación simultánea de la estadística, la programación informática y la investigación operativa para cuantificar el rendimiento.

● La analítica engloba un campo cada vez más amplio de capacidades de la ciencia de datos que incluye la estadística, las matemáticas, el aprendizaje automático, el modelado predictivo, la minería de datos, la informática cognitiva y la inteligencia artificial.

Capacidad Analítica

- La Ley de Moore en acción desde hace unos 35 años.

- Más recientemente, las habilidades analíticas aumentan gracias a la adición de núcleos en las unidades centrales.

Analítica (Categorías de la Analítica)

Figura 3: Cuatro tipos diferentes de análisis y su mayor valor

Inteligencia de Negocios

Definición

● La Inteligencia de Negocios (IN) comprende las estrategias y tecnologías utilizadas por las empresas para el análisis de datos de la información empresarial.

● La Inteligencia de Negocio emplea técnicas de análisis de datos y analíticas para consolidar y resumir la información que es específicamente útil en un contexto empresaria.

El principal reto de la Inteligencia de Negocios es:

● Consolidar los diferentes sistemas de información de la empresa y las fuentes de datos en un único almacén de datos integrado en el que se puedan realizar operaciones de análisis.

● Tener un almacén de datos es una (gran) base de datos centralizada en una organización que combina una variedad de diferentes bases de datos de diferentes fuentes.

Ejemplo

● Un ejemplo de Inteligencia de Negocios sería la construcción de un cuadro de mando de gestión que visualice los KPI clave de la empresa a través de diferentes divisiones en el mundo.

Figura 4: Estructura de la inteligencia de Negocios Tradicional

Big Data

El Big Data utiliza tanto técnicas de análisis de datos como analítica, y con frecuencia se basa en los datos de los almacenes de datos de la empresa (como los utilizados en el IB), como tal, puede considerarse el "siguiente paso" en la evolución

de la Inteligencia de Negocios (IN) o mejor conocido por sus siglas en Inglés (BI) Business Intelligence.

Big Data - ¿Por qué?

• Aumento exponencial de la cantidad de datos no estructurados.

• Correo electrónico, chat, blog, web, música, foto, vídeo, etc.

• Aumento de la capacidad de almacenamiento y análisis.

• El uso de varias máquinas en paralelo se hace accesible.

• Las tecnologías existentes no están diseñadas para ingerir estos datos.

• Bases de datos relacionales (tabulares), mainframes, hojas de cálculo (Excel), etc.

• Se necesitan "Nuevas" tecnologías y técnicas analíticas.

• "Google File System" - Google 2003.

• "MapReduce: Simplified Data Processing on Large Clusters" - Google, 2004.

• Hadoop: circa 2006.

• De ahí "Big Data": no estrictamente más datos.

Big Data Sigue un Enfoque Diferente al de la Inteligencia de Negocios

Los datos que se analizan en los entornos de Big Data son más grandes de lo que la mayoría de las soluciones de IN tradicionales pueden asumir, y por lo tanto requieren soluciones de almacenamiento y procesamiento distintas y distribuidas.

Los Big Data se caracterizan por la variedad de sus fuentes de datos e incluyen datos no estructurados o semi-estructurados, las soluciones de Big Data necesitan, por ejemplo, ser capaces de procesar imágenes de archivos de audio.

Diferencia entre Big Data e Inteligencia de Negocios (Representación Gráfica)

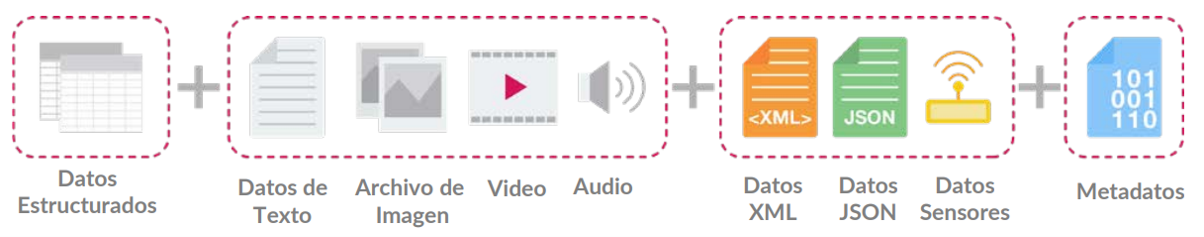

Datos y Tipos de Estructura de Datos

Definir los Datos

● Una estructura de datos es una colección de valores de datos, las relaciones entre ellos y las funciones u operaciones que pueden aplicarse a los datos.

Tipos de estructuras de datos

Existen tres tipos comunes de estructuras de datos:

● Datos no estructurados.

● Datos semi-estructurados.

● Datos estructurados.

Datos Estructurados:

- Los datos estructurados son datos que se adhieren a un modelo de datos predefinido y es, por lo tanto, sencillo de analizar.

- Los datos estructurados se ajustan a un formato tabular con relación entre las diferentes filas y columnas.

Ejemplo: Los datos estructurados son los archivos de Excel o bases de datos SQL, cada uno tiene filas y columnas estructuradas que pueden ser organizadas.

Datos Semi-estructurados:

● Los datos semi-estructurados son una forma de datos estructurados que no se ajustan a la estructura formal de los modelos de datos asociados con bases de datos relacionales u otras formas de tablas de datos, sin embargo contienen etiquetas u otros marcadores para separar elementos semánticos y hacen cumplir jerarquías de reportes y campos dentro de los datos. Por lo tanto, también se conoce como estructura auto-descriptiva.

● Ejemplo:

Datos semi-estructurados incluyen JSON y XML como formas de datos semiestructurados.

Datos No Estructurados:

● Los datos no estructurados son información que no tiene un modelo de datos pre-definido o no está organizado de una manera pre-definida.

● La información no estructurada suele contener mucho texto, pero puede llegar a contener datos tales como fechas, números y hechos que pueden resultar en irregularidades y ambigüedades. Ejemplo: Datos no estructurados incluyendo audio, archivos de video o bases de datos NoSQL.

● Metadata son datos sobre los datos. Provee información adicional sobre un grupo específico de datos.

Ejemplo: en un grupo de fotografías, los metadatos pueden describir cuándo y dónde se tomaron las fotos. Los metadatos proveen campos para fechas y ubicaciones las cuales, en sí mismas, pueden ser consideradas datos estructurados.

Tipos de Estructura de Datos (Representación Gráfica)

Figura 6: Los Cuatro Tipos de Datos

Productos de Datos y Soluciones de Big Data

● Un producto de datos es una aplicación que ejecuta análisis de datos u operaciones analíticas a partir de una determinada entrada, y que suele tener una interfaz de usuario fácil de entender.

● Los usuarios de los productos de datos no entienden exactamente todos los algoritmos subyacentes y solo son capaces de ejecutar ciertas consultas para encontrar respuestas especificas.

● Por lo tanto, la creación de productos de datos puede considerarse uno de los objetivos clave de Big Data.

Soluciones de Big Data

El marco de trabajo de Big Data se ha desarrollado desde una perspectiva independiente de los proveedores y, por lo tanto, no recomienda ninguna solución específica de Big Data.

Figura 7: Ejemplo de soluciones de Big Data populares

Una Solución de Big Data de Código Abierto

● Hadoop es un marco de software de código abierto utilizado para el almacenamiento distribuido y el procesamiento de conjuntos de datos de gran tamaño utilizando el modelo de programación MapReduce.

● Consiste en clusters de ordenadores construidos a partir de hardware básico, todos los módulos de Hadoop se han diseñado partiendo de la base de que los fallos de hardware son habituales y deben ser gestionados automáticamente por el marco.

● Es importante señalar que la mayoría de las soluciones de Big Data utilizan el marco Hadoop como marco de software subyacent; Por lo tanto, el término "Hadoop" también se conoce como el ecosistema que conecta diferentes soluciones de Big Data (y proveedores comerciales).

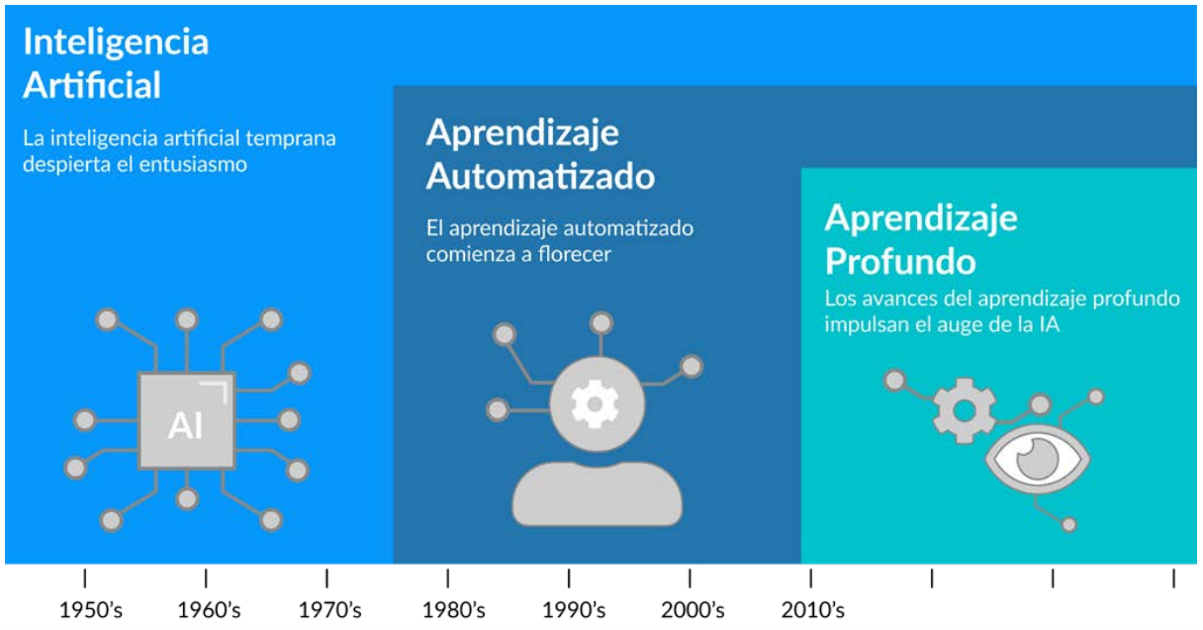

Inteligencia Artificial

● La Inteligencia Artificial (popularmente conocida como IA) es la inteligencia mostrada por las máquinas, en contraste con la inteligencia natural (IN) mostrada por los seres humanos y otros animales.

● La inteligencia artificial puede considerarse un dominio completo de la ciencia por sí misma, está fuertemente entrelazada con el Big Data porque el volumen y la variedad de las fuentes de datos son a menudo masivos (en términos de volumen) y diversos (en términos de sensores).

● Muchos de los algoritmos estadísticos y de aprendizaje automático que se utilizan para analizar conjuntos de Big Data, son como los que se utilizan en la Inteligencia Artificial Inteligencia Artifical (Ejemplo).

● Un ejemplo popular de aplicación de la IA son los coches auto-conducidos, el objetivo final de los coches auto-conducidos es imitar exactamente los mismos comportamientos que harían las personas "naturales" mientras conducen (o, preferiblemente, un comportamiento aún mejor sin ningún accidente).

● Los datos de entrada que hay que procesar tienen que proceder de distintos sensores (gran variedad) y deben procesar miles de señales cada segundo (gran velocidad y volumen) a medida que cambian las situaciones de tráfico.

La Evolución de IA, Aprendizaje Automatizado y Aprendizaje Profundo

Figura 8: The evolution of AI, Machine Learning and Deep Learning. Fuente: NVIDIA

Aprendizaje Automatizado (Machine Learning)

● El aprendizaje automatizado explora el estudio y la construcción de algoritmos que pueden aprender de los datos y hacer predicciones sobre ellos.

●El objetivo del aprendizaje automatizado es "enseñar" a los ordenadores a realizar determinadas operaciones (mediante la ejecución de algoritmos de aprendizaje automático), de modo que el ordenador pueda tomar mejores decisiones en el futuro y pueda "aprender" de situaciones anteriores.

● El aprendizaje automatizado se utiliza ampliamente para la minería de datos, que consiste en examinar grandes cantidades de datos para encontrar patrones desconocidos u ocultos.

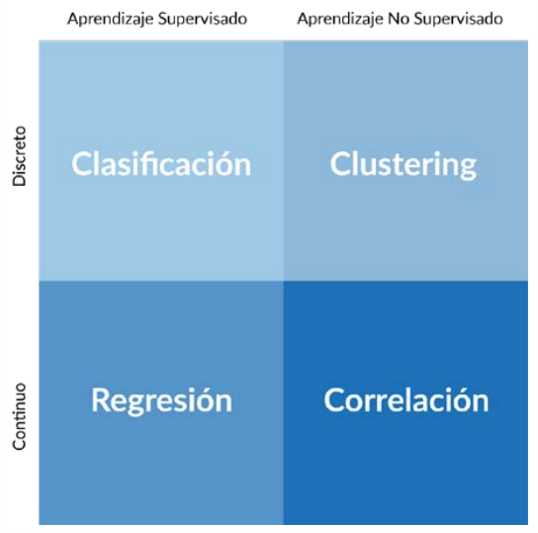

Clases de Aprendizaje Automatizado (Machine Learning)

En el nivel más alto, el aprendizaje automatizado puede subdividirse en dos clases diferentes:

●Aprendizaje automatizado supervisado: En el aprendizaje automatizado supervisado, un ordenador aprende una determinada tarea porque se le suministran datos de entrenamiento etiquetados.

Ejemplo:

Clasificar los mensajes de correo electrónico en una carpeta de spam o como correo normal, el ordenador tiene que "aprender" primero qué tipo de mensajes deben considerarse spam, alimentando un conjunto de datos de entrenamiento, después de que el ordenador "entienda" este conjunto de entrenamiento y derive ciertas reglas de él, puede clasificar los futuros correos electrónicos por sí mismo.

● Aprendizaje automatizado no supervisado, en este caso, un ordenador recibe datos y necesita inferir relaciones en los datos, sin ningún conocimiento previo sobre el conjunto de datos.

Ejemplo: Alimentar un ordenador con una gran cantidad de reclamaciones de seguros, basándose en algoritmos de aprendizaje no supervisado, el ordenador podría descubrir que algunas reclamaciones no se ajustan a un patrón regular y, por tanto, podrían ser fraudulentas; estos valores atípicos tendrían que ser evaluados y validados por los agentes de seguros.

Los Principales Ámbitos del Aprendizaje Automatizado

Figura 9: Los Principales Ámbitos del Aprendizaje Automático

Las 4 V’s del Big Data

● Volumen: La cantidad de datos generados en el mundo se duplica sin cesar cada 12-18 meses.

● Velocidad: Si los datos tradicionales son como un lago tranquilo, el Big Data es como un río rápido y furioso.

●Variedad: Si los datos tradicionales como facturas y libros de contabilidad eran como una pequeña habitación llena de datos, Big Data es como el mayor centro comercial imaginable que ofrece una variedad ilimitada.

● Veracidad: El Big Data es desordenado. Hay mucha desinformación y desinformación por ahí.

Volumen

● La cantidad de datos generados en el mundo se duplica sin cesar cada 12-18 meses.

● El Big Data se mide en Petabytes y Exabytes. No se puede almacenar en un solo dispositivo de almacenamiento. Necesita una red distribuida para almacenarlo todo.

● La razón principal del crecimiento de los datos es la drástica reducción del coste de su almacenamiento. Los costes de almacenamiento de datos han disminuido un 30-40 % cada año.

● Por lo tanto, existe un incentivo para registrar todo lo que se puede observar, es lo que se llama "dataficación".

Velocidad

● Los Big Data son generados por miles de millones de dispositivos y comunicados a la velocidad de la luz, a través de Internet.

● Ingerir todos estos datos es como beber de una manguera de incendios; uno no tiene ningún control sobre la velocidad a la que llegan los datos.

● La razón principal de la mayor velocidad de los datos es el aumento de la velocidad de Internet. Las velocidades de Internet disponibles en los hogares y las oficinas están pasando de 10MB/seg a 1GB/seg (100 veces más rápido). Cada vez más personas tienen acceso a Internet de alta velocidad en todo el mundo.

● Otra razón importante es la mayor variedad de fuentes, como los dispositivos móviles que pueden generar y comunicar datos desde cualquier lugar y en cualquier momento.

Variedad

● Big Data: incluye todas las formas de datos, para todo tipo de funciones, desde todas las fuentes y dispositivos. Hay tres aspectos:

● Forma de los datos: Los tipos de datos van desde los números hasta el texto, el gráfico, el mapa, el audio y el vídeo, entre otros. Algunos de estos tipos de datos son simples, mientras que otros son muy complejos.

●Función de los datos: Hay datos de conversaciones humanas, canciones y películas, registros de transacciones comerciales, datos de rendimiento de máquinas y operaciones, diseño de nuevos productos, archivos, etc.

● Fuente de datos: Comunicaciones hombre-hombre; comunicaciones hombre-máquina; y comunicaciones máquina-máquina.

Veracidad

● La veracidad se refiere a la veracidad, credibilidad y calidad de los datos.

● Sesgo: La fuente de información puede no ser autorizada.

● Error técnico o humano: Los datos pueden no ser comunicados y recibidos correctamente debido a un fallo humano o técnico.

● Los sensores: y las máquinas de recogida y comunicación de datos pueden funcionar mal y registrar y transmitir datos incorrectos.

● La urgencia: puede requerir la transmisión de los mejores datos, pero incompletos, disponibles en un momento dado.

●Intención maliciosa: Los datos proporcionados y recibidos, sin embargo, también pueden ser intencionalmente erróneos, por razones de competencia o de seguridad, puede haber desinformación e información maliciosa difundida por razones estratégicas.

Aplicaciones del Big Data

● Control y seguimiento de la ubicación, el consumo, etc.

● Análisis y conocimientos para el marketing, acciones específicas, etc.

● Desarrollo de productos basados en datos para productos digitales.

Gerencia de Big Data

● Céntrese en objetivos empresariales concretos para no sentirse abrumado, empiece por abordar los objetivos centrados en el cliente.

● Inicie las implantaciones piloto utilizando las fuentes de datos internas existentes y de nuevo acceso.

● La combinación de personas y datos es lo que permite obtener más información, construir o contratar habilidades y capacidades de Big Data.

● Cuanto antes se analicen los datos, mayor será su valor predictivo.

● No desechar los datos si no se les ve un uso inmediato. Los datos suelen tener un valor que va más allá de lo que se prevé inicialmente.

● Planifique para un crecimiento exponencial, construir un entorno de procesamiento de información resistente, seguro, eficiente, flexible y en tiempo real.

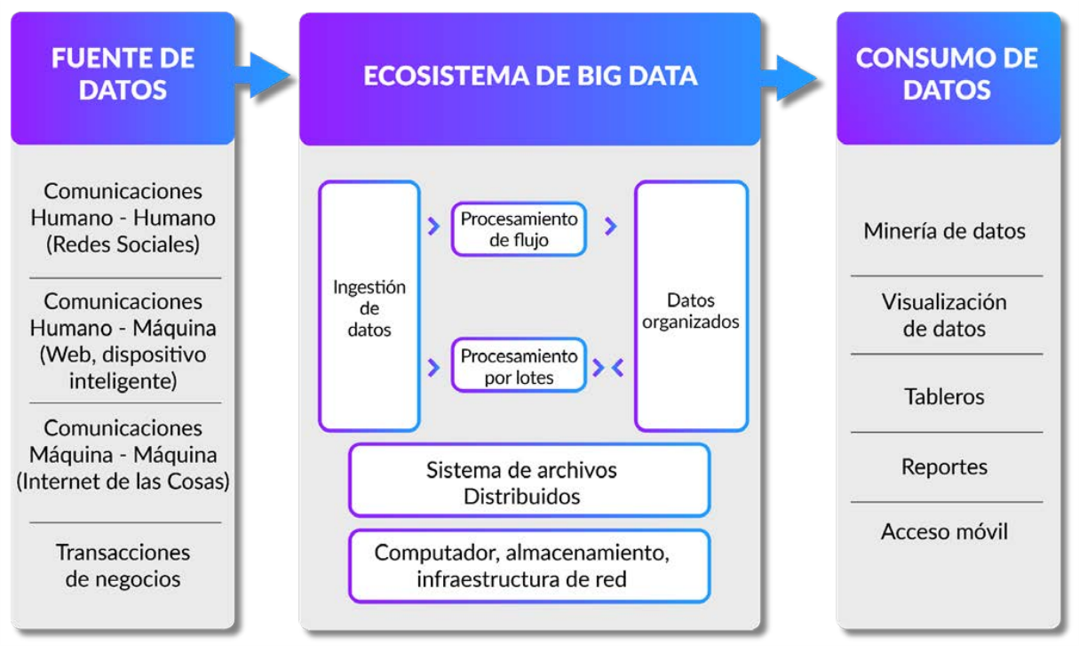

Ecosistema de Big Data

Analizando Big Data

● Procesamiento de flujos, para obtener estadísticas de alto nivel en tiempo real sobre los datos.

● Procesamiento por lotes, que utiliza técnicas analíticas estándar para generar información.

● Binning Data, para reducir a menos categorías significativas.

Panel de Control en Tiempo Real

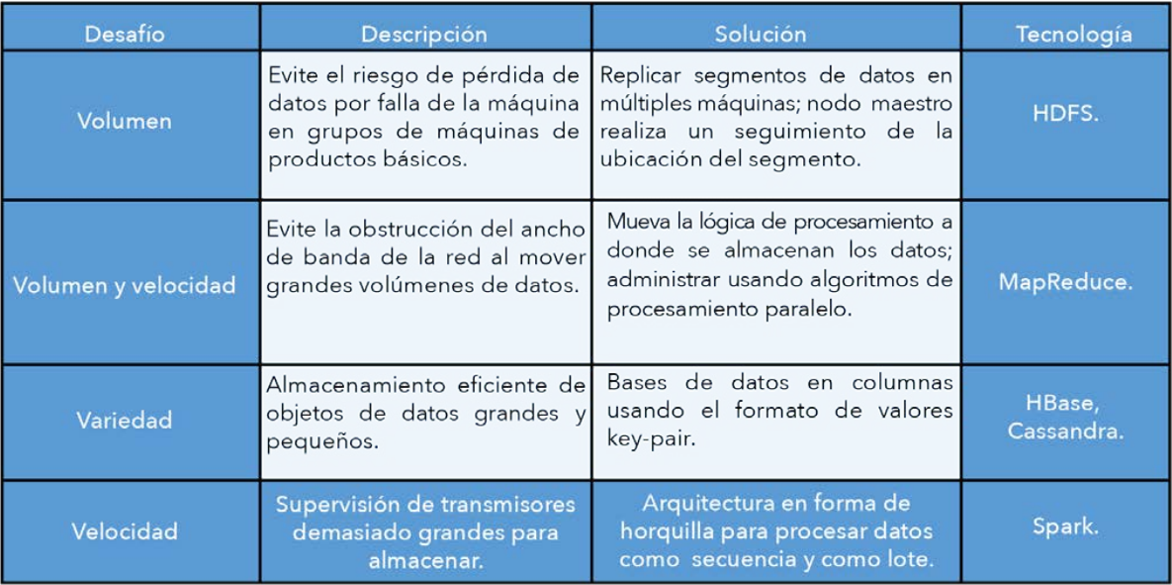

Desafíos Técnicos de Big Data

Desafío #1: Almacenar enormes cantidades de datos.

● Ninguna máquina de almacenamiento es lo suficientemente grande para almacenar la cantidad de datos que crece incesantemente, es necesario almacenar en un gran número de máquinas más pequeñas y económicas.

● Existe el inevitable reto del fallo de las máquinas, el fallo de una máquina podría suponer la pérdida de los datos almacenados en ella.

Solución: Distribuir los datos en un gran clúster escalable de máquinas económicas.

● Asegura que cada dato se replique sistemáticamente en varias máquinas para garantizar que al menos una copia esté siempre disponible.

● Añade más máquinas según sea necesario.

● Hadoop es un sistema muy conocido para gestionar grandes volúmenes.

Desafío #2: Ingesta y procesamiento de flujos a un ritmo extremadamente rápido.

● Flujos de datos imprevisibles y torrenciales, demasiado grandes para ser almacenados, pero que deben ser supervisados.

Solución: Crear sistemas de ingesta escalables.

● Pueden abrir un número ilimitado de canales para recibir datos. Los datos pueden mantenerse en colas, desde las que las aplicaciones empresariales pueden leer y procesar los datos a su propio ritmo y conveniencia. Apache Kafka es un popular sistema de ingesta dedicado.

● El motor de procesamiento de flujos puede hacer su trabajo mientras el procesamiento por lotes hace su trabajo. Apache Spark es el sistema más popular para aplicaciones de streaming.

Desafío #3: Manejar una gran variedad de formas y funciones de datos.

● Almacenarlos en estructuras planas o relacionales tradicionales sería demasiado impráctico, derrochador y lento. Acceder a ellos y analizarlos requiere capacidades diferentes.

Solución: Utilizar sistemas no relacionales que relajen muchas de las estrictas condiciones del modelo relacional.

● Son las llamadas bases de datos NoSQL (Not Only SQL). Estas bases de datos están optimizadas para determinadas tareas, como el procesamiento de consultas, o el procesamiento de gráficos, el procesamiento de documentos, etc.

● HBase y Cassandra son dos de los sistemas de bases de datos NoSQL más conocidos.

Desafío #4: Procesar las enormes cantidades de datos.

● Mover grandes cantidades de datos desde el almacenamiento al procesador consumiría una enorme capacidad de red y ahogaría la red.

Solución: Trasladar el procesamiento al lugar donde se almacenan los datos.

● Distribuir la lógica de las tareas en el clúster de máquinas donde se almacenan los datos.

● Las máquinas trabajan en paralelo sobre los datos que se les han asignado.

● Un proceso de seguimiento consolida las salidas intermedias y entrega los resultados finales.

● MapReduce, inventada por Google, es la tecnología más conocida para el procesamiento en paralelo.

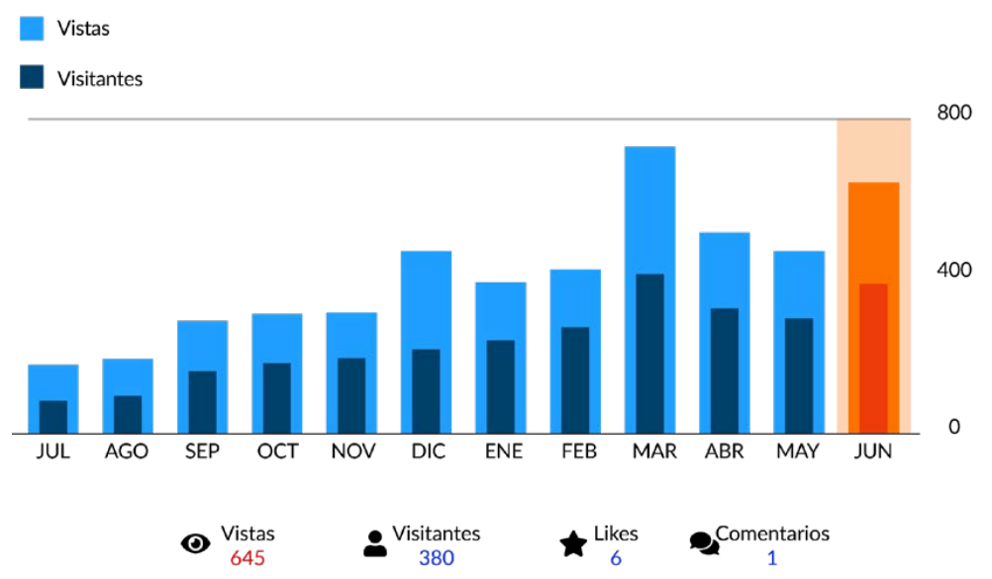

Resumen de Desafíos y Soluciones

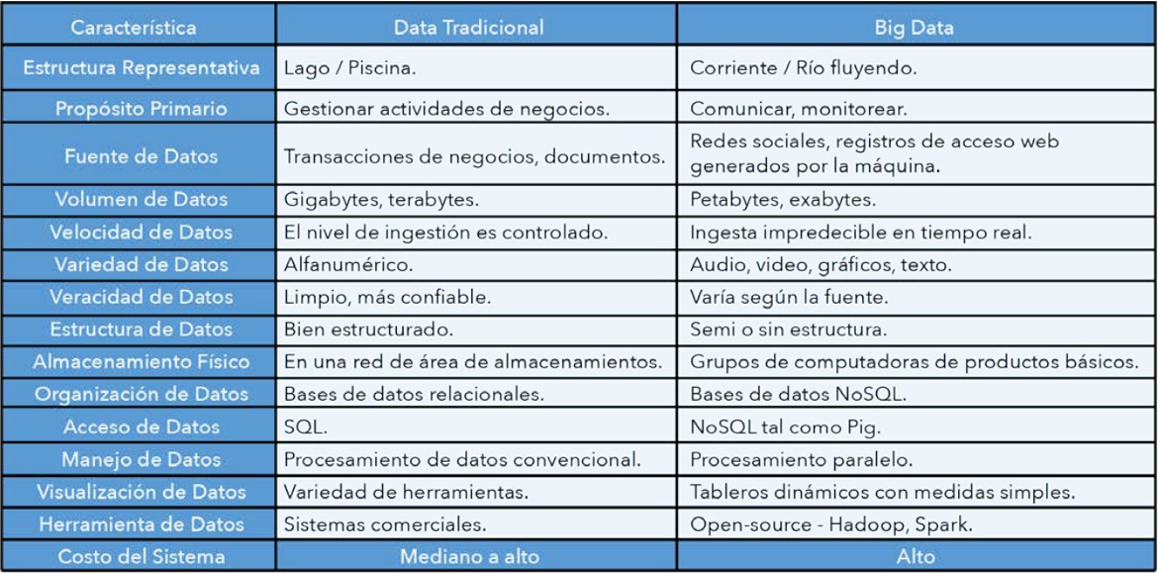

Comparación Entre los Datos Tradicionales y Big Data

Preguntas de Repaso

1. ¿Qué es el Big Data? ¿Por qué debería importarle a alguien?

2. Describa el modelo de las 4 V de Big Data.

3. ¿Cuáles son los principales retos tecnológicos en la gestión de Big Data?

4. ¿Cuáles son las tecnologías disponibles para gestionar el Big Data?

5. ¿Qué tipo de análisis se pueden hacer con Big Data?

6. Vea al CEO de Cloudera presentar la evolución de Hadoop en https://www.youtube.com/watch?v=S9xnYBVqLws. ¿Por qué la gente no prestó atención a Hadoop y MapReduce cuando se presentó? ¿Qué implicaciones tiene para las tecnologías emergentes?

Ejercicio del Caso Liberty Stores: Paso B1

Liberty Stores Inc, es una cadena minorista global especializada que vende alimentos orgánicos, ropa orgánica, productos para el bienestar y productos educativos a los ciudadanos LOHAS (Estilos de vida saludables y sostenibles) iluminados de todo el mundo, la empresa tiene 20 años y está creciendo rápidamente. Ahora opera en 5 continentes, 50 países, 150 ciudades y tiene 500 tiendas. Vende 20000 productos y tiene 10000 empleados, la empresa tiene unos ingresos de más de 5.000 millones de dólares y tiene un beneficio de aproximadamente el 5% de sus ingresos, la empresa presta especial atención a las condiciones de cultivo y producción de sus productos. Dona alrededor de una quinta parte (20%) de sus beneficios antes de impuestos de causas benéficas locales globales.

1. Sugerir una estrategia integral de Big Data para el director general de la empresa.

2. ¿Cómo puede ayudar a esta empresa un sistema de Big Data como IBM Watson?