Objetivos del Aprendizaje

● Comprender la necesidad de un sistema de ingesta dedicado para Big Data

● Comprender los tipos de arquitecturas de sistemas de mensajería

● Entender el sistema de mensajería Kafka y sus muchas características beneficiosas

● Comprender la sencilla arquitectura de Kafka, incluyendo los conceptos clave de productores, consumidores, brokers y temas de datos

● Comprender los numerosos casos de uso de Kafka

● Comprender Zookeeper y su papel de apoyo a Kafka

Arquitectura de Big Data

Sistema de Ingesta de Datos

● Un Sistema de ingesta de datos es un punto de recepción confiable y eficiente para todos los datos en un sistema

● Buffer rápido y flexible para recibir y almacenar todos los flujos de datos entrantes. Los datos en el buffer son almacenados de manera secuencial

● Los datos están disponibles para todas las aplicaciones consumidoras en una manera rápida y ordenada

Sistemas de Mensajería

● Sistema fiable y rápido para conectar emisores y receptores de mensajes

● Sistemas punto a punto

- Bien entendido

- Ineficiente para grandes volúmenes

● Sistemas de publicación-suscripción

- Los intermediarios navegan por las relaciones entre productores y consumidores de datos

- Muy escalables y rápidos

- Apache Kafka es uno de estos sistemas

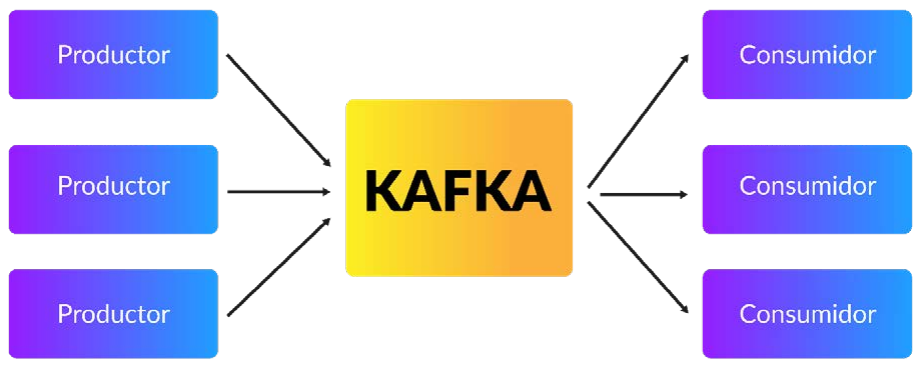

Arquitectura Apache Kafka

Componentes de Kafka

● Productores

● Consumidores

● Corredores

● Temas

● Zookeeper - Publica los metadatos

Mecanismo de Temas Kafka

● Los productores escriben datos secuencialmente en un conjunto de temas

● Los datos se replican en 3 particiones

● Los datos se almacenan durante siete días

● Los consumidores pueden suscribirse a cualquier número de temas

● Los datos se consumen secuencialmente

● Los consumidores llevan la cuenta de los desplazamientos de los datos que han leído

● Los consumidores pueden leer desde cualquier partición

Atributos Clave de Kafka

● Basado en discos: Kafka trabaja en un conjunto de discos, no guarda todo en la memoria, y sigue escribiendo en el disco para que el almacenamiento sea permanente.

● Tolerante a fallos: Los datos de Kafka se replican entre varios brokers. Cuando algún broker líder falla, un broker seguidor toma el relevo como líder y todo sigue funcionando con normalidad.

● Escalable: Kafka puede ampliarse fácilmente añadiendo más particiones o más corredores, más corredores ayudan a repartir la carga y esto proporciona un mayor rendimiento

● Baja latencia: Kafka procesa muy poco los datos. Por lo tanto, tiene una tasa de latencia muy baja, Los mensajes producidos por el consumidor se publican y están disponibles para el consumidor en unos pocos milisegundos

● Retención finita: Kafka por defecto mantiene el mensaje en el cluster durante una semana, después, el almacenamiento se actualiza, así, los consumidores de datos tienen hasta una semana para ponerse al día con los datos

Preguntas de Repaso

1. ¿Qué es un sistema de ingesta de datos? ¿Por qué es un tema importante?

2. ¿Cuáles son las dos formas de entregar datos de muchas fuentes a muchos objetivos?

3. ¿Qué es Kafka? ¿Cuáles son sus ventajas? Describe 3 casos de uso de Kafka

4. ¿Qué es un tema? ¿Cómo ayuda a la gestión de la ingesta de datos?